Τίτλοι τέλους για την ανάπτυξη της τεχνολογίας CSAM της Apple, που θα της έδινε τη δυνατότητα να ελέγχει τις φωτογραφίες σας στο iCloud για εικόνες παιδικής σεξουαλικής κακοποίησης. Το Child Sexual Abuse Material αποκαλύφθηκε πέρυσι το φθινόπωρο, προκαλώντας έντονες αντιδράσεις από ειδικούς κρυπτογράφησης και ιδιωτικότητας, καθώς ενέχει τον κίνδυνο δημιουργίας ενός συστήματος παρακολούθησης το οποίο θα λειτουργεί απευθείας από το τηλέφωνό σας, το laptop ή το tablet σας.

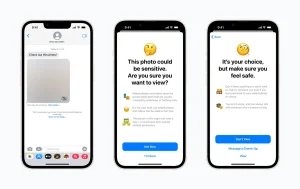

Παρόλα αυτά, η Apple κυκλοφόρησε μία μορφή της CSAM τεχνολογίας με το iOS 15.2 και την ονόμασε “communication safety in iMessage”, όπου ο χρήστης μπορεί να επιλέξει από τις ρυθμίσεις Family Sharing της εφαρμογής Messages, να φιλτράρει εισερχόμενες και εξερχόμενες φωτογραφίες σεξουαλικού περιεχομένου σε λογαριασμούς παιδιών.

Αν εντοπίσει κάτι που θεωρεί πως ξεπερνά τα όρια, θολώνει την εικόνα και εμφανίζει ένα pop-up μήνυμα με οδηγίες βοήθειας ή μπλοκαρίσματος του αποστολέα. Το αρχικό σχέδιο ήταν να ειδοποιεί αυτόματα και το γονέα, αλλά στην πράξη αυτό παρέμεινε μόνο μία επιλογή για το χρήστη.

Τώρα, σύμφωνα με τη Wall Street Journal, η ανάπτυξη του CSAM σταματά και δίνεται έμφαση στην ιδιωτικότητα του χρήστη. Η εταιρία σχεδιάζει να επεκτείνει την κρυπτογράφηση απ’ άκρη σε άκρη για να συμπεριλαμβάνει τα backups του iPhone, προσθέτοντας νέα χαρακτηριστικά με στόχο τη διατήρηση της ιδιωτικότητας και της ασφάλειας κατά τη χρήση του iMessage και δεδομένων που αποθηκεύονται στο iCloud.

Πηγή: unboxholics.com